Pengertian Transformer, jenis dan fungsinya merupakan topik menarik dalam dunia pemrosesan bahasa alami. Transformer, arsitektur revolusioner dalam deep learning, telah mengubah cara kita mendekati tugas-tugas seperti terjemahan mesin dan analisis sentimen. Bayangkan sebuah mesin yang mampu memahami nuansa bahasa manusia, bahkan menghasilkan teks yang kreatif dan koheren—itulah kekuatan Transformer.

Artikel ini akan mengupas tuntas arsitektur dasar Transformer, komponen-komponen utamanya, mekanisme attention yang inovatif, serta perbandingannya dengan arsitektur tradisional seperti RNN dan CNN. Kita akan menjelajahi berbagai jenis Transformer seperti BERT, GPT, dan T5, membandingkan keunggulan dan kekurangannya, dan melihat bagaimana mereka diterapkan dalam berbagai aplikasi dunia nyata. Siap untuk menyelami dunia Transformer?

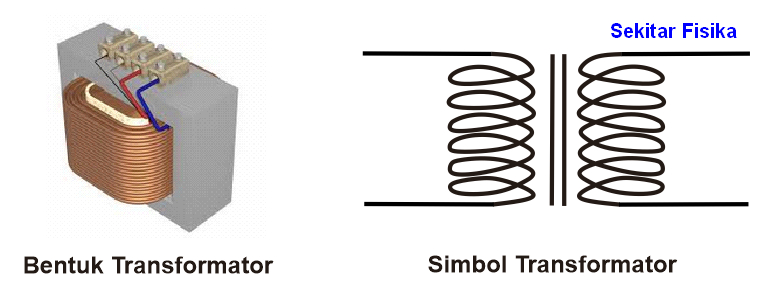

Pengertian Transformer

Transformer adalah arsitektur jaringan saraf tiruan yang revolusioner dalam bidang pemrosesan bahasa alami (NLP). Berbeda dengan arsitektur sebelumnya seperti Recurrent Neural Network (RNN) dan Convolutional Neural Network (CNN), Transformer mengandalkan mekanisme

-attention* untuk memproses urutan data, memungkinkan pemrosesan paralel dan pemahaman konteks yang lebih baik.

Arsitektur Dasar Transformer dan Komponen Utama

Arsitektur Transformer terdiri dari dua komponen utama: encoder dan decoder. Encoder memproses input teks dan menghasilkan representasi vektor yang menangkap makna dan konteks kata-kata. Decoder kemudian menggunakan representasi ini untuk menghasilkan output, misalnya terjemahan atau teks yang dihasilkan. Kedua komponen tersebut terdiri dari beberapa lapisan yang identik, masing-masing mengandung mekanisme

-self-attention* dan

-feed-forward network*. Mekanisme

-attention* memungkinkan model untuk fokus pada bagian-bagian penting dari input saat memprosesnya.

Mekanisme Attention pada Transformer

Mekanisme

-attention* adalah inti dari Transformer. Ia memungkinkan model untuk mempertimbangkan hubungan antara semua kata dalam urutan input secara simultan, bukan secara berurutan seperti pada RNN. Dengan menghitung skor perhatian antara setiap pasangan kata, model dapat menentukan seberapa relevan setiap kata terhadap kata lain dalam konteks kalimat. Skor perhatian yang lebih tinggi menunjukkan hubungan yang lebih kuat.

Proses ini memungkinkan model untuk menangkap dependensi jarak jauh antara kata-kata, yang merupakan tantangan bagi arsitektur RNN.

Perbandingan Transformer dengan RNN dan CNN, Pengertian Transformer, jenis dan fungsinya

Berbeda dengan RNN yang memproses data secara berurutan, Transformer memproses data secara paralel, membuatnya jauh lebih efisien untuk data yang panjang. CNN, meskipun dapat memproses data paralel, kurang efektif dalam menangkap dependensi jarak jauh antara kata-kata seperti yang dilakukan oleh Transformer. Transformer unggul dalam pemrosesan bahasa alami karena kemampuannya untuk menangkap konteks dan hubungan yang kompleks antara kata-kata dalam kalimat.

Contoh Penerapan Transformer dalam Tugas Pemrosesan Bahasa Alami

Transformer telah diterapkan dalam berbagai tugas NLP, termasuk terjemahan mesin, analisis sentimen, pembuatan teks, penjawab pertanyaan, dan peringkasan teks. Kemampuannya untuk memproses data paralel dan menangkap dependensi jarak jauh membuatnya sangat efektif dalam tugas-tugas ini.

Tabel Perbandingan Transformer dan Model Bahasa Lainnya

| Nama Model | Keunggulan | Kekurangan | Contoh Aplikasi |

|---|---|---|---|

| Transformer | Pemrosesan paralel, pemahaman konteks yang baik, mampu menangani data sekuensial panjang | Membutuhkan daya komputasi yang tinggi, model yang besar | Terjemahan mesin, analisis sentimen, pembuatan teks |

| RNN (LSTM, GRU) | Mudah diimplementasikan, efektif untuk data sekuensial pendek | Pemrosesan berurutan, sulit menangani data sekuensial panjang, rentan terhadap vanishing gradient | Pengenalan ucapan, prediksi deret waktu |

| CNN | Pemrosesan paralel, efektif untuk ekstraksi fitur lokal | Kurang efektif dalam menangkap dependensi jarak jauh | Pengolahan citra, klasifikasi teks |

Jenis-jenis Transformer

Beberapa arsitektur Transformer yang populer telah dikembangkan, masing-masing dengan desain dan tujuan yang sedikit berbeda. Ketiga arsitektur ini, BERT, GPT, dan T5, telah memberikan kontribusi signifikan dalam perkembangan NLP.

Arsitektur Transformer Populer: BERT, GPT, dan T5

BERT (Bidirectional Encoder Representations from Transformers) adalah model

-encoder-only* yang dilatih dengan teknik

-masked language modeling* dan

-next sentence prediction*. GPT (Generative Pre-trained Transformer) adalah model

-decoder-only* yang dilatih dengan teknik

-language modeling*. T5 (Text-to-Text Transfer Transformer) adalah model yang merumuskan semua tugas NLP sebagai masalah

-text-to-text*, menggunakan baik encoder maupun decoder.

Perbandingan Arsitektur BERT, GPT, dan T5

Perbedaan utama terletak pada arsitektur dan tugas pelatihan. BERT menggunakan encoder untuk memahami konteks kata-kata dalam kalimat, sedangkan GPT menggunakan decoder untuk menghasilkan teks. T5 menggunakan keduanya dan mengkonversi semua tugas menjadi format input-output teks.

- BERT: Bidirectional, encoder-only, unggul dalam tugas pemahaman konteks.

- GPT: Unidirectional, decoder-only, unggul dalam tugas generasi teks.

- T5: Encoder-decoder, merumuskan semua tugas sebagai masalah text-to-text.

BERT efektif untuk tugas klasifikasi dan pemahaman konteks seperti analisis sentimen dan penjawab pertanyaan. GPT unggul dalam menghasilkan teks yang koheren dan kreatif, seperti menulis cerita atau puisi. T5 menawarkan fleksibilitas yang tinggi karena mampu menangani berbagai tugas NLP dengan arsitektur yang sama.

Fungsi Transformer

Fungsi utama Transformer dalam konteks pemrosesan bahasa alami adalah untuk memahami dan menghasilkan teks dengan akurasi dan efisiensi yang tinggi. Kemampuannya dalam menangkap konteks dan hubungan antara kata-kata memungkinkan model untuk melakukan berbagai tugas NLP dengan performa yang jauh lebih baik dibandingkan model tradisional.

Contoh Penerapan Transformer dalam Berbagai Tugas

Transformer digunakan dalam terjemahan mesin untuk menerjemahkan teks dari satu bahasa ke bahasa lain dengan akurasi yang tinggi. Dalam analisis sentimen, Transformer dapat mengklasifikasikan teks sebagai positif, negatif, atau netral. Untuk pembuatan teks, Transformer dapat menghasilkan teks yang koheren dan kreatif, seperti artikel berita atau cerita fiksi.

Peran Transformer dalam Meningkatkan Performa Model Bahasa

Transformer meningkatkan performa model bahasa dengan kemampuannya untuk memproses data secara paralel dan menangkap dependensi jarak jauh antara kata-kata. Hal ini memungkinkan model untuk memahami konteks yang lebih luas dan menghasilkan output yang lebih akurat dan koheren.

Pengolahan Data Sekuensial dengan Panjang Variabel

Transformer mampu menangani data sekuensial dengan panjang variabel dengan menggunakan mekanisme

-attention*. Model tidak perlu memproses data secara berurutan, sehingga dapat memproses data dengan panjang yang berbeda secara efisien.

Contoh Penerapan Transformer dalam Sistem Chatbot

Dalam sistem chatbot, Transformer dapat digunakan untuk memahami maksud pengguna dan menghasilkan respons yang relevan dan kontekstual. Model dapat mempelajari pola percakapan dari data pelatihan yang besar dan menghasilkan respons yang alami dan human-like.

Ilustrasi Kerja Transformer

Proses Encoding dan Decoding serta Peran Attention Mechanism

Proses encoding dimulai dengan mengubah setiap kata dalam kalimat input menjadi representasi vektor (word embeddings). Lapisan encoder kemudian memproses vektor-vektor ini secara paralel menggunakan mekanisme

-self-attention*, yang memungkinkan model untuk mempertimbangkan hubungan antara semua kata dalam kalimat. Hasil dari lapisan encoder adalah representasi vektor yang menangkap makna dan konteks seluruh kalimat. Decoder kemudian menerima representasi vektor ini sebagai input dan menghasilkan output teks secara bertahap, kata demi kata.

Pada setiap langkah, mekanisme

-attention* memungkinkan decoder untuk fokus pada bagian-bagian penting dari representasi vektor yang dihasilkan oleh encoder, untuk menghasilkan kata berikutnya yang relevan dengan konteks.

Ngomongin Transformer, kita tau kan alat ini penting banget buat naikin-turunin tegangan listrik? Ada berbagai jenisnya, mulai dari step-up sampai step-down, fungsinya pun beragam banget di berbagai aplikasi. Eh, ngomong-ngomong soal tegangan, ternyata untuk stabilisasi tegangan kita juga butuh komponen lain, lho! Misalnya Zener Diode, yang fungsinya mengatur tegangan agar tetap stabil. Kalian bisa baca lebih lanjut tentang Pengertian Zener Diode, jenis dan fungsinya untuk memahami lebih detail.

Nah, kembali ke Transformer, pemahaman tentang regulasi tegangan seperti yang dilakukan Zener Diode ini penting banget untuk optimasi kinerja Transformer, supaya nggak terjadi kerusakan akibat fluktuasi tegangan.

Penggunaan dan Pemrosesan Word Embeddings

Word embeddings adalah representasi vektor kata yang menangkap makna semantik dan sintaksisnya. Transformer menggunakan word embeddings sebagai input untuk lapisan encoder. Setiap kata direpresentasikan sebagai vektor numerik yang menangkap hubungannya dengan kata-kata lain dalam ruang vektor. Lapisan encoder kemudian memproses vektor-vektor ini untuk menghasilkan representasi yang lebih kaya yang menangkap konteks dan hubungan antara kata-kata dalam kalimat.

Mekanisme Attention dalam Memfokuskan Bagian Penting Input Teks

Mekanisme

-attention* memungkinkan model untuk memfokuskan pada bagian-bagian penting dari input teks dengan menghitung skor perhatian antara setiap pasangan kata. Skor perhatian yang lebih tinggi menunjukkan hubungan yang lebih kuat antara kata-kata. Dengan memfokuskan pada kata-kata yang relevan, model dapat menangkap konteks yang lebih akurat dan menghasilkan output yang lebih baik. Misalnya, dalam kalimat “Anjing itu mengejar bola merah”, mekanisme

-attention* akan memberikan skor perhatian yang tinggi pada kata “Anjing” dan “bola merah”, karena kata-kata ini memiliki hubungan yang kuat dalam konteks kalimat.

Simpulan Akhir

Transformer telah merevolusi pemrosesan bahasa alami, menawarkan peningkatan signifikan dalam akurasi dan efisiensi dibandingkan model tradisional. Memahami arsitektur, jenis, dan fungsi Transformer adalah kunci untuk mengapresiasi kemajuan pesat dalam bidang kecerdasan buatan. Dengan pemahaman yang mendalam tentang kemampuannya, kita dapat mengharapkan inovasi yang lebih luar biasa di masa depan, membuka jalan bagi aplikasi yang lebih canggih dan bermanfaat.

FAQ dan Solusi: Pengertian Transformer, Jenis Dan Fungsinya

Apa perbedaan utama antara self-attention dan cross-attention?

Self-attention memperhatikan hubungan antar kata dalam satu kalimat, sedangkan cross-attention memperhatikan hubungan antar kata di antara dua kalimat (misalnya, dalam terjemahan mesin).

Apakah Transformer selalu lebih baik daripada RNN dan CNN untuk semua tugas?

Ngomongin Transformer, kita pasti paham kan tentang alat yang mengubah tegangan listrik? Ada berbagai jenisnya, mulai dari step-up sampai step-down, fungsinya pun beragam banget, dari menyesuaikan tegangan untuk perangkat elektronik sampai di sistem distribusi listrik. Nah, bayangin aja, kerja Transformer ini mirip kayak saklar, cuma lebih kompleks! Kalau mau tau lebih detail tentang saklar, cek aja di sini Pengertian Saklar, jenis dan fungsinya , untuk ngebandingin prinsip kerjanya.

Intinya, Transformer dan saklar sama-sama komponen penting dalam rangkaian listrik, cuma cara kerjanya yang beda. Kembali ke Transformer, pemahaman mendalam tentang jenis dan fungsinya penting banget, lho, untuk aplikasi di berbagai bidang.

Tidak selalu. Meskipun Transformer unggul dalam banyak tugas pemrosesan bahasa alami, RNN dan CNN masih relevan dan mungkin lebih efisien untuk tugas-tugas tertentu.

Bagaimana Transformer menangani data dengan panjang yang sangat besar?

Teknik seperti positional encoding dan mekanisme attention yang efisien memungkinkan Transformer untuk menangani data sekuensial dengan panjang variabel, meskipun dengan batasan komputasi.